模型训练的过程是什么过程_数据预处理到对齐的完整流程

来源:健身美体 2025-12-21 14:20:01 阅读:()

文章目录:

正文:

模型训练的过程究竟是怎样的?它并非简单的数据输入与结果输出,而是一系列严谨且复杂的工程步骤。从原始数据的收集到最终模型的部署,每一步都蕴含着深度的技术与策略考量。在这个过程中,模型逐渐学习、适应并,最终实现其设计目标。让我们深入探讨这一过程的核心环节,揭示模型训练背后的奥秘。

数据预处理:模型训练的基石

在模型训练的宏伟蓝图中,数据预处理占据着至关重要的位置。如果直接将网络上杂乱无章的网页、聊天记录或图片文件一股脑地塞进模型,结果会是怎样?模型的性能必然大打折扣,甚至可能“学坏”。因此,数据预处理成为模型训练不可或缺的第一步。

这一过程包括清洗、整理和标准化原始数据,确保它们成为模型可理解的格式。就像在烹饪前需要清洗、切配食材一样,模型在“吃数据”之前,也必须经过这一系列繁琐但必要的准备工作。原始数据往往充满杂乱、冗余和格式不统一的问题,需要经过精心处理,才能转化为干净、规范、表达清晰的输入,为后续的训练奠定坚实基础。

如何确保数据预处理的品质呢?通过细致的筛选和分段,例如GPT系列模型在训练前对上千TB数据的严格处理,只选取其中的部分作为训练集。专门的数据过滤pipeline(如WebGPT Filter)被设计出来,以保障预处理的无误。这些措施不仅提升了数据的质量,也为模型的训练效果提供了有力保障。

Tokenization:将文本转化为模型能理解的数字语言

Tokenization是大模型预处理中最关键的一步。现代语言模型并非直接“读取文本”,而是将文本拆解成一个个Token(符号单元)后输入模型中。不同的模型使用不同的Tokenizer(如BPE、SentencePiece、tiktoken等),但它们的目标相同:将文本“转化成模型能理解的数字语言”。

这一过程的重要性不言而喻。如果原始数据质量差、脏话多、格式乱,模型很容易“学坏”。同时,没有分词、格式混乱、图文不匹配都会影响模型的理解与生成效果。因此,Tokenization不仅关乎模型能否理解输入,更关乎其能否泛化到其他任务。

预训练:为模型打下通用能力的基础

预训练是指在大规模通用数据(如网页文本、图书、代码、图片等)上,对模型进行无监督或自监督学习,使其学会如何理解语言结构、逻辑推理、上下文信息等。这一阶段就像一个孩子博览群书,逐渐学会语言、记住一些规律,拥有泛化常识。

预训练的目的是让模型成为一个“通用预训练模型”(Foundation Model),为所有后续任务准备好通用能力。例如,OpenAI的GPT-3是在45TB原始文本中筛选后的570GB文本上进行预训练的,包含书籍、维基百科、Reddit评论、代码等。这一阶段不仅需要数千块GPU的强大算力,还需要几百万美元的投入。

预训练后的模型,就像一个博览群书但还没上岗的“新员工”,需要后续微调与对齐,才能真正上手工作。微调是如何让模型更好地适应特定任务的?

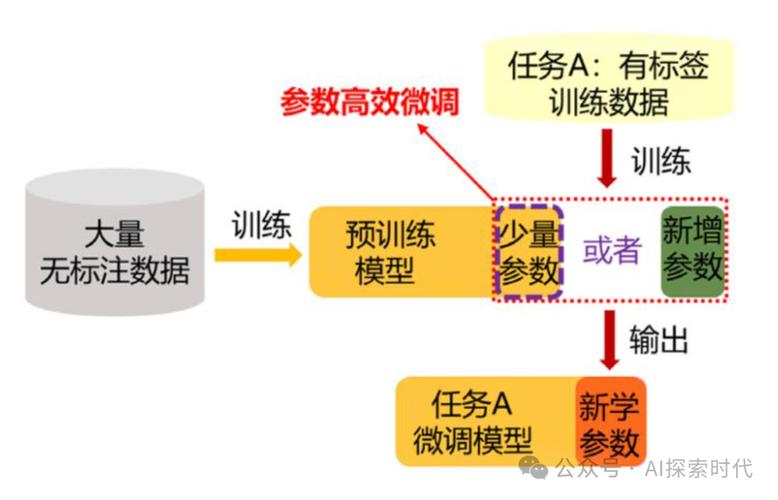

微调:让模型掌握特定技能

微调是在预训练模型的基础上,继续使用小规模、的专用数据,对其进行有监督的训练,使其学会特定任务。微调的方式多种多样,取决于你希望模型掌握哪类技能。例如,通过成千上万个类似的问答指令对,模型学会了如何根据“提示”完成具体任务。

以DeepSeek系列模型为例,其从V1到V3的演进过程,就是不断进行指令微调(Instruction Tuning)和对话微调(Dialog Fine-tuning)的结果。DeepSeek V2开始能“听懂人话”、有对话节奏感,而DeepSeek V3则融入了多轮对话记忆、对话风格控制等能力,甚至在2024年的中文评测中表现优于很多商业闭源模型。

微调不仅提升了模型的性能,还使其更加符合人类的预期。例如,通过微调,模型可以避免生成不恰当的内容,使其在回答问题时更加得体、有逻辑、有责任感。

对齐:确保模型“按人类预期回答”

当模型完成了预训练和微调后,虽然已经具备了强大的理解和生成能力,但它可能并不总是“按人类预期回答”。例如,它可能会生成不连贯、不相关或具有偏见的内容。为了解决这个问题,需要对齐(Alignment)技术应运而生。

对齐技术的目的是调整模型的行为,使其更符合人类的价值观和期望。这可以通过多种方式进行,例如:

- 人类反馈强化学习(RLHF):通过收集人类对模型输出的反馈,并使用强化学习算法来调整模型的行为。

- 指令微调:使用包含人类意图和偏好的指令数据来微调模型。

- 内容过滤:在模型输出内容之前,使用过滤器来移除不恰当的内容。

通过这些技术,模型可以更好地理解人类的意图,生成更符合人类期望的内容。例如,经过对齐训练的模型在回答问题时,会更加得体、有逻辑、有责任感,避免了生成不恰当或有害的内容。

模型训练的过程,就像“养成一个AI”的逐步过程,经历了数据预处理、Tokenization、预训练、微调和对齐五个关键阶段。每个阶段都至关重要,共同构成了模型训练的完整流程。通过这一过程,模型逐渐学习、适应并,最终实现其设计目标。

在这个过程中,我们不仅可以看到人工智能技术的魅力,还可以感受到工程师们的智慧与付出。模型训练的过程,不仅是对技术的挑战,更是对人类智慧的考验。只有不断探索、不断创新,才能推动人工智能技术的发展,为人类社会带来更多福祉。

如果你对模型训练的过程感兴趣,不妨深入了解每个阶段的具体细节,尝试自己动手训练一个模型。在这个过程中,你不仅能够学习到人工智能的知识,还能体验到创造的乐趣。

参考资料

1. 科普大模型是怎么“被训练出来”的?——从数据到能力的全过程拆解_大模型训练、推理、部署的全流程逻辑-CSDN博客

2. flux lora训练基于青龙圣者训练脚本,保姆级脸模lora训练全流程超详细讲解,8G显存也可炼丹,lora训练_哔哩哔哩_bilibili

3. Lora模型两步训练法,让自己训练自己,效果炸裂!_哔哩哔哩_bilibili

4. flux lora训练基于秋叶lora训练整合包,从数据集到出图全流程避坑指南,保姆级LoRA训练效率提升教程