大语言模型训练过程_四阶段解锁语言模型强大表现

来源:健身美体 2026-01-22 13:30:01 阅读:()

文章目录:

正文:

大语言模型(如ChatGPT)的“智能”并非凭空而来,而是经历了一个复杂而精密的训练过程。这个训练过程如同雕塑艺术的创作,每一道工序都需精心雕琢,方能成就一件传世之作。本文将深入剖析ChatGPT的四阶段构建流程,揭示其从数据到智能的蜕变过程。

预训练:语言规律的初探

预训练阶段是大模型训练的基石。在这一阶段,模型的核心任务是学习语言规律与世界知识。一个新生儿通过不断听到的声音和看到的画面来学习语言,大模型也是如此。预训练模型能够“续写文本”,却还不懂“指令”。这一阶段的目的是让模型理解人类需求,为后续的微调阶段打下基础。在这个过程中,数据规模、算法类型和计算资源需要精准匹配,才能确保模型在基础能力上的坚实构建。

预训练阶段的数据通常来源于大量的文本资料,如书籍、新闻、文章等。模型通过自监督学习的方式,不断其参数,从而能够更好地理解和生成语言。这一阶段的技术细节涉及到了许多复杂的算法,如Transformer、BERT等,它们能够有效地捕捉文本中的长距离依赖关系。

微调:精准指令的理解

在预训练的基础上,微调阶段进一步提升了模型对人类指令的理解能力。这一阶段的目标是让模型能够更好地理解用户的意图,并生成更加精准的回复。微调阶段通常使用较小的数据集,但这些数据集经过精心筛选,能够有效地提升模型在特定任务上的表现。

微调阶段的技术细节同样复杂,涉及到参数的调整和。模型通过不断学习新的数据和任务,逐渐适应不同的场景和需求。在这个过程中,计算资源的合理分配显得尤为重要,因为微调阶段的计算需求通常比预训练阶段更高。

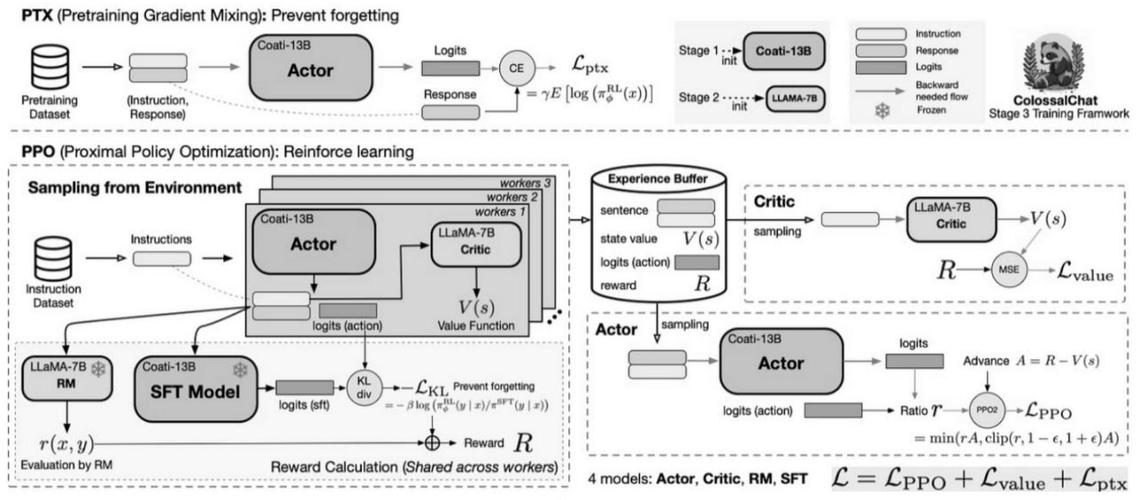

奖励建模:智能表现的

奖励建模阶段是大模型训练中的关键环节。这一阶段的目标是通过奖励机制来模型的智能表现。奖励建模通常涉及到人类评估者的参与,他们根据模型的回复给出奖励或惩罚,从而引导模型学习到更加符合人类需求的回答。

奖励建模阶段的技术细节同样复杂,涉及到奖励函数的设计和。模型通过不断学习奖励信号,逐渐其参数,从而能够生成更加符合人类期望的回复。这一阶段的数据通常来自于人类评估者的反馈,因此数据的质量和数量对模型的效果至关重要。

强化学习:智能表现的持续提升

强化学习阶段是大模型训练中的最后一环,也是最为关键的一环。这一阶段的目标是通过强化学习机制来持续提升模型的智能表现。强化学习通常涉及到一个智能体(即模型)和一个环境(即任务),智能体通过不断尝试和反馈来其策略,从而能够在环境中取得更好的表现。

强化学习阶段的技术细节同样复杂,涉及到策略梯度和奖励信号的设计。模型通过不断学习环境和任务的反馈,逐渐其策略,从而能够在不同的场景中取得更好的表现。这一阶段的数据通常来自于模型在环境中的尝试和反馈,因此数据的数量和质量对模型的效果至关重要。

大语言模型的训练过程是一个复杂而精密的过程,涉及到多个阶段的精心设计和。从预训练到微调,再到奖励建模和强化学习,每一个阶段都至关重要。在这个过程中,数据规模、算法类型和计算资源的精准匹配是确保模型智能表现的关键。通过不断的学习和,大语言模型能够逐渐提升其智能表现,为人类提供更加便捷和高效的服务。

参考资料:

1. 大模型原理剖析——拆解预训练、微调、奖励建模与强化学习四阶段(以ChatGPT构建流程为例)

2. 大语言模型(如ChatGPT - 掘金)